Una interfaz para controlar simultáneamente varios robots

Investigadores de la Universidad Politécnica de Madrid desarrollan una interfaz de realidad virtual que permite a un solo operador supervisar misiones con múltiples robots.

15.10.2018

Investigadores del Grupo de Robótica y Cibernética (RobCib) del Centro de Automática y Robótica (CAR) – un centro mixto de la Universidad Politécnica de Madrid (UPM) y el Consejo Superior de Investigaciones Científicas (CSIC) – han desarrollado una nueva herramienta para optimizar el trabajo de los operadores de robots. Utilizando la realidad virtual, la herramienta permite introducir al operador en el escenario donde los robots están desarrollando la misión. De esta forma, puede moverse por la escena buscando el mejor lugar para observar y dirigir con precisión a los robots para que realicen sus tareas. Los resultados obtenidos muestran que esta interfaz proporciona a los operadores una mejor consciencia de la situación además de una menor carga de trabajo.

Cuando oímos hablar de robótica, pensamos inmediatamente en robots. Nos imaginamos una flota de drones buscando víctimas tras un desastre natural, un grupo de robots humanoides como guías de museo o un equipo de robots terrestres aplicando tratamientos a cultivos. Es una asociación de lo más habitual y, sin embargo, al hacerla nos olvidamos de los otros grandes protagonistas de la robótica: los operadores. Estas personas son las que planifican las rutas de los robots en el museo, interpretan las imágenes de los drones, organizan el rescate de las víctimas o señalan a los robots las plantas que deben tratar. Por una vez vamos a hablar de ellos.

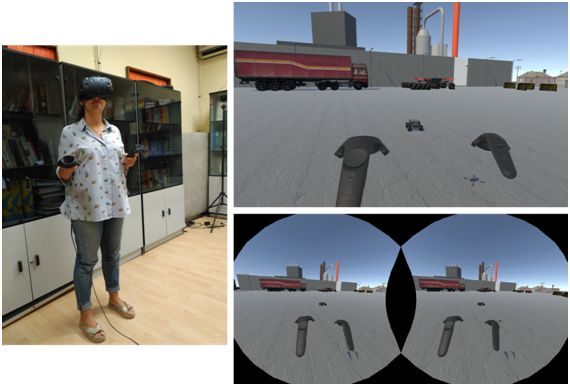

Investigadora inmersa en una misión. Fuente: UPM.

Ser operador de robots no es un trabajo fácil. Hay que gestionar una gran carga de trabajo, consistente en interpretar la información de la misión, tomar decisiones y generar comandos para los robots. Además, hay que mantener una buena consciencia de la situación, lo que significa ser capaz de reconstruir el escenario a partir de los datos obtenidos por los robots, y saber dónde se encuentran y qué están haciendo estos en cada momento. Como señala Juan Jesús Roldán, investigador de RobCib, “actualmente las misiones requieren más operadores que robots: lo más habitual es que haya uno para controlar los movimientos y otro para analizar los datos de cada robot. El objetivo es que, dentro de unos años, un solo operador sea capaz de controlar simultáneamente varios robots”.

Con el fin de acercarse a este objetivo, un equipo de investigadores del CAR (UPM-CSIC) ha desarrollado una interfaz que emplea la realidad virtual para introducir al operador en el escenario donde los robots están desarrollando la misión. Además, la interfaz utiliza técnicas de aprendizaje automático para evaluar la importancia y el riesgo de cada robot en la misión, como lo haría un operador humano. Esta información se muestra al operador de forma intuitiva: por ejemplo, un foco que apunta al dron que realiza la tarea más crítica y una columna de humo que sale de un dron que está en peligro.

Durante la investigación se organizaron un conjunto de experimentos para probar la nueva interfaz y compararla con otra convencional. En estas pruebas, un grupo de operadores tuvo que supervisar un conjunto de misiones con drones de detección y extinción de incendios empleando ambas interfaces. Los resultados demostraron que la interfaz de realidad virtual proporcionaba a los operadores una mejor consciencia de la situación (estos percibían mejor las rutas de los robots y las tareas realizadas por cada uno) y además una menor carga de trabajo (estos declaraban un menor esfuerzo, mayor rendimiento y menor frustración).

La misión realizada en el laboratorio junto a la vista de la interfaz de realidad virtual. Fuente: UPM.

Los próximos pasos del trabajo de investigación consistirán en integrar una mayor variedad de escenarios (exteriores e interiores) y robots (terrestres y aéreos) y probar nuevos métodos para que los operadores comanden los robots de forma cómoda e intuitiva. En este vídeo se puede ver la interfaz en acción: en la primera mitad, cómo los eventos de la misión se reproducen en la realidad virtual; y en la segunda, cómo un operador se desenvuelve durante la misión.

Este trabajo se ha realizado dentro del proyecto SAVIER (Situational Awareness VIrtual EnviRonment) de Airbus y ha supuesto una colaboración entre la Universidad Politécnica de Madrid, donde se desarrollaron las interfaces, y la Universidad de Luxemburgo, donde se realizaron los experimentos con drones. Los resultados han sido publicados por la revista Sensors.

Juan Jesús Roldán, Elena Peña-Tapia, Andrés Martín-Barrio, Miguel A. Olivares-Méndez, Jaime Del Cerro and Antonio Barrientos. Multi-Robot Interfaces and Operator Situational Awareness: Study of the Impact of Immersion and Prediction. Sensors 2017, 17(8), 1720; https://doi.org/10.3390/s17081720.

Enlaces de interés:

Tesis Doctoral: http://www.jjrg.org/p/thesis.html

Trabajo Final de Grado: http://oa.upm.es/47538/